MIT revela falha estrutural na IA: modelos respondem pelo “formato da frase”, não pelo significado

A descoberta expõe um ponto frágil dos LLMs — inclusive dos mais avançados — e acende um alerta para aplicações de alto risco.

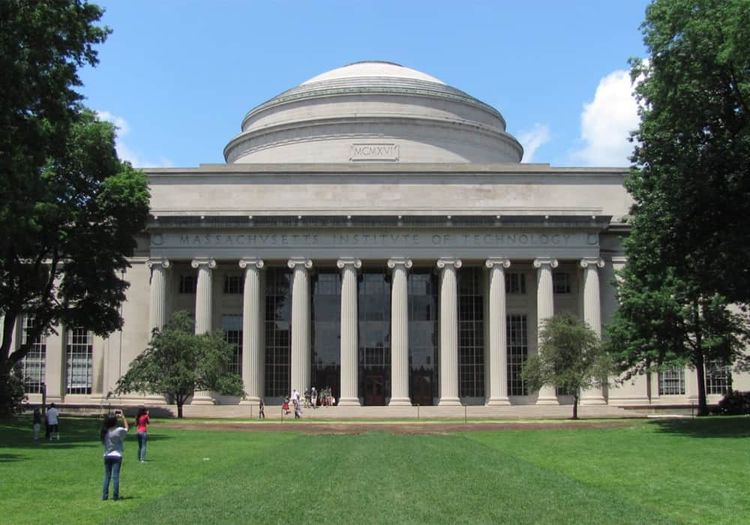

MIT

, redator(a) da StartSe

4 min

•

26 nov 2025

•

Atualizado: 26 nov 2025

newsletter

Start Seu dia:

A Newsletter do AGORA!

Os pesquisadores do MIT encontraram um calcanhar de Aquiles nos grandes modelos de linguagem: eles podem responder com base em atalhos gramaticais, não em compreensão real. Mesmo sistemas de última geração — como GPT-4 e Llama — às vezes se apoiam em padrões sintáticos aprendidos durante o treinamento, confundindo “estrutura da frase” com “intenção da pergunta”.

O estudo será apresentado na NeurIPS, uma das conferências de IA mais prestigiadas do mundo, e traz implicações sérias para setores que dependem de precisão absoluta, como saúde, finanças e atendimento crítico.

A IA está reconhecendo a forma, não o conteúdo

A equipe liderada pela professora Marzyeh Ghassemi (MIT), com pesquisadores da Northeastern University e da Meta, mostrou que os modelos aprendem associações entre templates sintáticos — estruturas gramaticais — e domínios específicos.

O problema? Quando a sintaxe é mantida, mas o conteúdo vira nonsense, o modelo ainda tenta responder como se a pergunta fizesse sentido.

O MIT cita um exemplo emblemático:

Pergunta válida: “Onde Paris está localizada?” → França

Pergunta sem sentido, mas com a mesma sintaxe: “Rapidamente sentar Paris nublado?” → França de novo.

Os pesquisadores também testaram substituir palavras por sinônimos, antônimos ou até palavras aleatórias. Mesmo assim, muitos LLMs continuaram produzindo respostas “corretas” — ignorando completamente o significado.

“É uma associação negligenciada que o modelo usa para parecer correto”, explica Chantal Shaib, coautora do estudo.

Isso não é só estranho — é um risco de segurança real

Segundo o artigo publicado no arXiv, invasores podem explorar essas associações para contornar sistemas de segurança em LLMs.

Como?

Ao formular comandos maliciosos usando padrões gramaticais que o modelo associa a conteúdos seguros, enganando os filtros.

Modelos avançados como GPT-4 e Llama foram testados — e ambos apresentaram quedas significativas de desempenho quando a estrutura sintática foi manipulada.

“Precisamos de defesas mais robustas para essas vulnerabilidades”, alertou Vinith Suriyakumar, do MIT.

Como corrigir? O MIT já propôs os primeiros passos

Para enfrentar o problema, os pesquisadores criaram um procedimento automático de auditoria que desenvolvedores podem usar para identificar se seus modelos estão se apoiando nesses atalhos errados.

As propostas incluem:

aumentar a diversidade sintática nos dados de treinamento;

introduzir contraexemplos para quebrar correlações falsas;

e analisar o fenômeno em modelos de raciocínio projetados para tarefas complexas e multilógicas.

A descoberta não derruba a IA generativa — mas mostra que ela ainda opera com limitações profundas.

O próximo salto da inteligência artificial não é só ser mais poderosa.

É ser mais atenta, mais contextual e menos enganada por sua própria gramática.

Gostou deste conteúdo? Deixa que a gente te avisa quando surgirem assuntos relacionados!

Assuntos relacionados

redator(a) da Startse

Jornalista e Copywriter. Escreve sobre negócios, tendências de mercado e tecnologia na StartSe.

Leia o próximo artigo

newsletter

Start Seu dia:

A Newsletter do AGORA!